Suchmaschinen-Roboter

Die Commerce-Konfiguration enthält Einstellungen zur Erstellung und Verwaltung von Anweisungen für Web-Crawler und Bots, die Ihre Website indizieren. Wenn die Anfrage für robots.txt Commerce erreicht (und nicht eine physische Datei), wird sie dynamisch an den Robots-Controller weitergeleitet. Die Anweisungen sind Direktiven, die von den meisten Suchmaschinen erkannt und befolgt werden.

Standardmäßig enthält die von Commerce generierte robots.txt-Datei Anweisungen für Web-Crawler, die Indizierung bestimmter Teile der Website zu vermeiden, die Dateien enthalten, die intern vom System verwendet werden. Sie können die Standardeinstellungen verwenden oder Ihre eigenen benutzerdefinierten Anweisungen für alle oder für bestimmte Suchmaschinen definieren. Es gibt viele Artikel im Internet, die sich ausführlich mit diesem Thema befassen.

Beispiel: Benutzerdefinierte Anweisungen

Erlaubt vollen Zugriff

1

2

Benutzer-Agent:*

Nicht zulassen:

Verweigert den Zugriff auf alle Ordner

1

2

Benutzer-Agent:*

Nicht zulassen: /

Standard-Anweisungen

1

2

3

4

5

6

7

8

9

10

Nicht zulassen: /lib/

Nicht zulassen: /*.php$

Nicht zulassen: /pkginfo/

Nicht zulassen: /report/

Nicht zulassen: /var/

Nicht zulassen: /katalog/

Disallow: /Kunde/

Disallow: /sendfriend/

Disallow: /Rezension/

Disallow: /*SID=

Konfigurieren Sie robots.txt

-

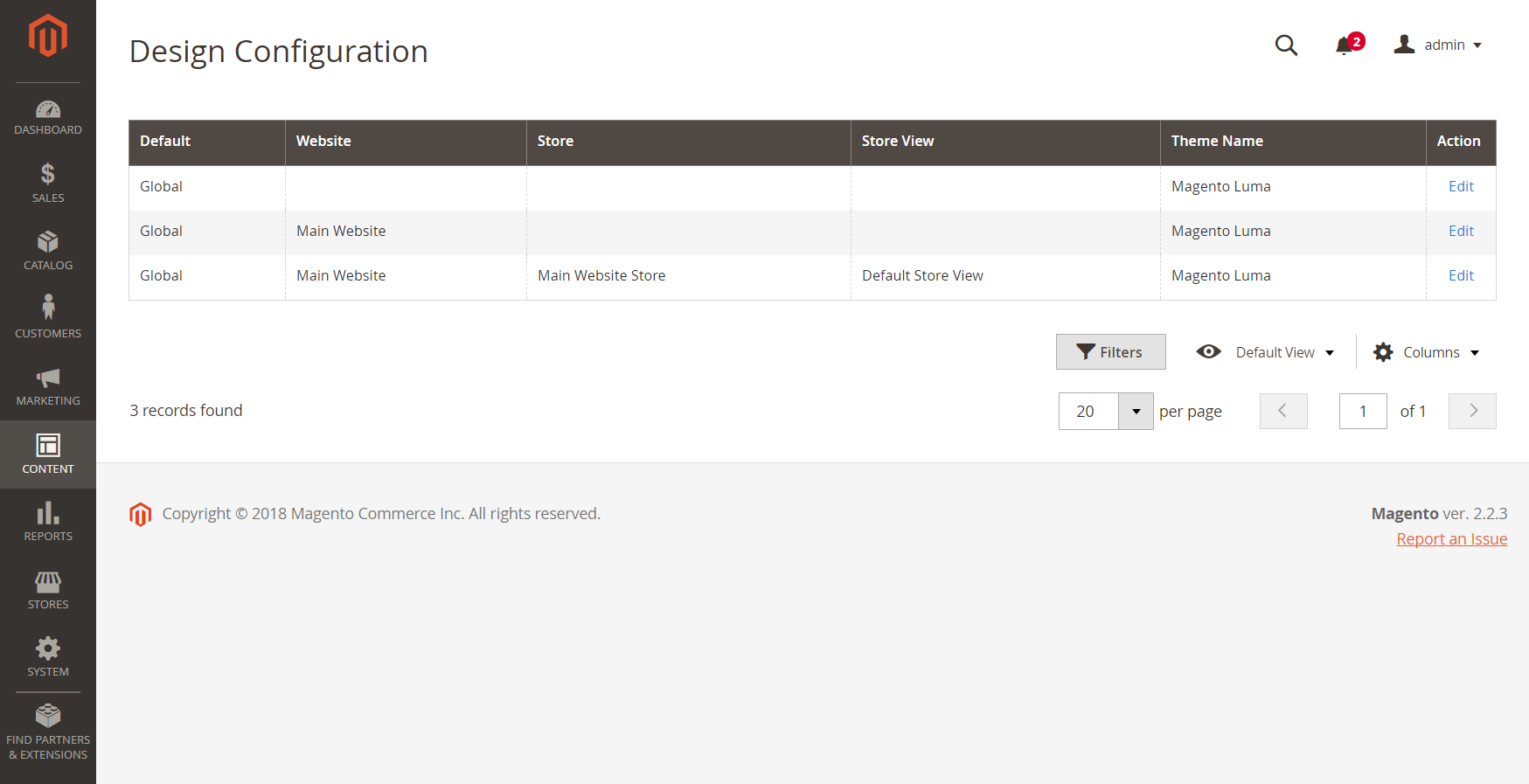

Gehen Sie in der Seitenleiste von Admin auf Inhalt > Design > Konfiguration.

-

Suchen Sie die Konfiguration Global in der ersten Zeile des Rasters und klicken Sie auf Bearbeiten.

Globale Designkonfiguration

Globale Designkonfiguration -

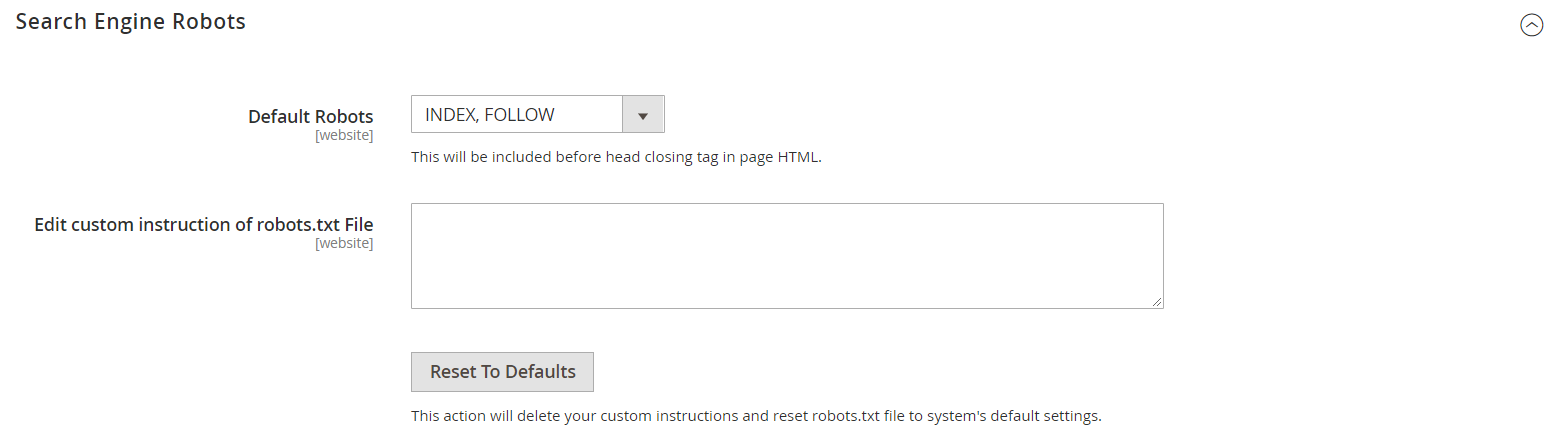

Scrollen Sie nach unten und erweitern Sie

den Abschnitt Search Engine Robots und machen Sie folgendes:

den Abschnitt Search Engine Robots und machen Sie folgendes: Suchmaschinen-Robots

Suchmaschinen-Robots-

Setzen Sie Standard-Robots auf einen der folgenden Werte:

INDEX, FOLLOW Weist Webcrawler an, die Seite zu indizieren und später auf Änderungen zu prüfen. NOINDEX, FOLGEN Weist Webcrawler an, die Seite nicht zu indizieren, aber später nach Änderungen zu suchen. INDEX, NOFOLLOW Weist Webcrawler an, die Seite einmal zu indizieren, aber später nicht mehr auf Änderungen zu prüfen. NOINDEX, NOFOLLOW Weist Webcrawler an, die Seite nicht zu indizieren und später nicht auf Änderungen zu prüfen. -

Geben Sie bei Bedarf benutzerdefinierte Anweisungen in das Feld Benutzerdefinierte Anweisung der robots.txt-Datei bearbeiten ein. Während eine Website entwickelt wird, können Sie beispielsweise den Zugriff auf alle Ordner verbieten.

-

Um die Standardanweisungen wiederherzustellen, klicken Sie auf Auf Standard zurücksetzen.

-

-

Wenn Sie fertig sind, klicken Sie auf Konfiguration speichern.